ИИ процессоры, серверы и суперкомпьютеры для бизнеса

Обновлено: 10.10.2024 |

Специализированное компьютерное железо (hardware) для систем машинного обучения (начиная от процессоров и заканчивая дата-центром) - позволяют значительно ускорить и удешевить обучение нейросетей. Примеры таких специализированных систем - даны ниже.

2024. Nvidia создала ИИ чат-бот, работающий непосредственно на компьютере

Компания Nvidia представила Chat with RTX, позволяющий владельцам видеокарт GeForce RTX 30 и 40 серий запускать чат-бота на основе ИИ в автономном режиме на ПК с Windows. Chat with RTX использует LLM-модели Mistral, а также Llama 2 от Meta, Nvidia предупреждает, что скачивание всех необходимых файлов сможет занять от 50 до 100 ГБ памяти. Nvidia признает, что на релевантность ответов программы может влиять целый ряд факторов, в том числе формулировка вопроса, производительность выбранной модели и размер набора данных для точной настройки. Также существует целый ряд известных проблем и ограничений. Например, попытка проиндексировать с помощью Chat with RTX папку из 25 000 документов привела к сбою программы, требовавшей сброса всех настроек для восстановления работоспособности.

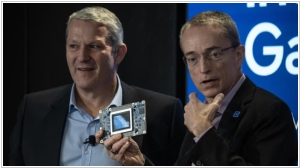

2023. Intel анонсировал новый чип для систем искусственного интеллекта

Компания Intel анонсировала новый нейрочип Gaudi3 для систем искусственного интеллекта. Он появится в продаже в следующем году и будет конкурировать с аналогами Nvidia и AMD, которые используют мощные AI-модели. Самые известные модели искусственного интеллекта, такие как ChatGPT от OpenAI, работают на графических процессорах от Nvidia в облаке. Это одна из причин, почему акции Nvidia выросли почти на 230% в этом году, тогда как акции Intel – всего лишь на 68%. Также это привело к тому, что компании, такие как AMD, а теперь и Intel -представили свои чипы, надеясь потеснить Nvidia на рынке. Intel также делает ставку на персональные компьютеры с искусственным интеллектом. Для них предназначен новый процессор Core Ultra, представленный одновременно с Gaudi3. Акции Intel после презентации поднялись на 1%.

2023. Microsoft представила собственные AI-чипы

Корпорация Microsoft разработала два нейропроцессора: один — для обучения больших языковых моделей, чтобы не зависеть от поставщиков чипов, второй — для дата-центров, обеспечивающих работу облачных сервисов компании. Что один, что другой чипы предназначаются для удовлетворения как собственных потребностей компании, ЦОД Azure, так и для предоставления корпоративным клиентам. Чипы называются Azure Maia и Azure Cobalt. Оба базируются на архитектуре ARM и станут более-менее массово использоваться в дата-центрах компании. Насколько можно понять, компания планирует и заработать, поставляя чипы корпоративным клиентам. Вероятно, заработать можно неплохо, судя по успехам Nvidia, которая также поставляет высокопроизводительные чипы для ИИ-сервисов. Графические чипы от Nvidia быстро стали дефицитным товаром, сейчас в рознице цены на них достигают $60 000 США и даже выше.

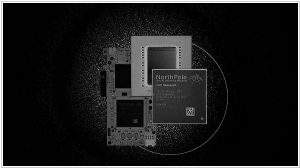

2023. IBM создала энергоэффективный процессор для ИИ

Корпорация IBM представила NorthPole - нейропроцессор своей внутренней разработки, предназначенном для ресурсоёмких приложений, связанных с искусственным интеллектом (ИИ). Как утверждает разработчик, этот процессор значительно превосходит конкурирующие устройства в плане энергоэффективности. Разработчики отталкивались от конструктивных решений предшествующего ИИ-оптимизированного процессора TrueNorth. Однако Northpole примерно в 4000 раз быстрее. Из-за тесного расположения микросхем памяти и ядер, процесс передачи данных занимает минимальное время. Это снижает и задержки вычислений, связанные с перемещением данных, а значит - повышает производительность. Ещё одним достоинством микросхем памяти, встроенных прямо в ядра, является повышение энергоэффективности процессора. Чем ближе друг к другу области памяти и вычислений, тем меньше энергии уходит.

2023. Google представил 5 поколение своих TPU-процессоров

Google представил 5 поколение своих тензорных нейропроцессоров для машинного обучения TPU. Они доступны только в облаке Google Cloud. Компания отмечает, что при создании этой версии чипа особое внимание уделялось эффективности. По сравнению с предыдущим поколением, эта версия обещает обеспечить двукратное улучшение производительности обучения на доллар и 2,5-кратное улучшение производительности обученной модели на доллар. В дополнение к следующему поколению TPU компания также объявила, что в следующем месяце она сделает графические процессоры Nvidia H100 доступными для разработчиков.

2022. Esperanto - 1000-ядерный «самый быстрый» ИИ-процессор на базе открытой архитектуры

Стартап Esperanto Technologies представил процессор, который насчитывает более 1000 ядер RISC-V общего назначения. Разработчики считают, что он будет демонстрировать высокую производительность и энергоэффективность при применении в сфере ИИ. Процессор ET-SoC1 сами создатели определяют как «ускоритель логических выводов ИИ» (AI Inference Accelerator). Он насчитывает 1088 энергоэффективных 64-разрядных процессорных ядер, использующих набор инструкций RISC-V, с собственными модулями векторных/тензорных вычислений для ускорения операций, связанных с машинным обучением. Процессор содержит также четыре высокопроизводительных ядра RISC-V, 160 млн байт встроенной SRAM-памяти (152 мегабайта) и интерфейсы для подключения flash-памяти и внешних модулей DRAM.

2022. Qpisemi представила ИИ-процессор для дата-центров

Индийская компания Qpisemi анонсировала новые процессоры, специально для решения задач, связанных с искусственным интеллектом. Разработчики утверждают, что эти чипы будут в 100 превосходить по производительности современные GPU, используемые в дата-центрах. Процессоры AI 2.0, созданные на базе полупроводниковой фотоэлектроники, предполагается использовать в системах, предназначенных для решения таких задач как биоинформатика, разработка новых лекарственных препаратов, моделирование ИИ, оптимизация, создание метавселенных и производство оборудования.

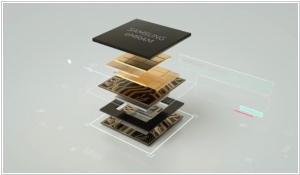

2022. Samsung продемонстрировал вычисления в памяти на базе MRAM

Компания Samsung Electronics представила микросхему MRAM (магниторезистивной памяти с произвольным доступом) для вычислений в памяти, заменив стандартную архитектуру вычислений с «текущей суммой» на новую архитектуру, работающую с «суммой сопротивлений», которая решает проблему малых сопротивлений отдельных устройств MRAM. Вычисления в памяти MRAM были протестированы в работе с операциям ИИ. Чип достиг точности 98% в распознавании рукописных цифр и 93 % в обнаружении лиц в сценах. Исследователи отмечают, что использование MRAM, производство которой уже достигло коммерческих масштабов, для вычислений в памяти расширяет возможности по разработке чипов искусственного интеллекта следующего поколения с низким энергопотреблением.

2021. Amazon представила новый чип для машинного обучения на AWS

Amazon представила чип Trn1, специально созданный для задач глубокого обучения. Этот продукт, как отмечают наблюдатели, напрямую будет соперничать с чипами от Nvidia. Производитель ожидает, что обучение моделей машинного обучения с использованием Trn1 будет обходиться на 40% дешевле, чем на платформах конкурентов. Инстансы будут предлагать сетевую пропускную способность до 800 Гбит/с. Кроме того, из них можно будет формировать кластеры из десятков тысяч систем. Экземпляры Trn1 доступны в предварительной версии. Несмотря на разработку собственных чипов AWS по-прежнему тесно сотрудничает с Intel, AMD и Nvidia. Браун заявил, что его компания предпринимает все усилия, чтобы сохранить конкуренцию в сегменте, предлагая потребителям выбор процессорных платформ.

2021. Rain Neuromorphics представила нейропроцессор из 10 тыс нейронов

Компания Rain Neuromorphics разработала цифровой процессор, который содержит 10 тыс. цифровых нейронов. Его выпустят с использованием 180-нанометрового техпроцесса. Разработчики говорят, что воспроизвели работу дендритов с небывалой точностью. К каждому аксону цифрового нейрона подведено множество дендритов. Также синапсы находятся в месте соединения дендритов и аксонов, только это уже электрический контакт. Разработчики ставили себе задачу создать разреженные матрицы — в процессе работы они будут производить нейронную сеть, это похоже на то, что происходит в человеческом мозге во время обучения. Авторы отмечают, что их разработка сможет обеспечить 125 млн параметров INT8 для обработки зрения, речи, естественного языка. Потребление энергии будет на уровне менее 50 Вт. Производство первых коммерческих образцов начнется в 2024 году.

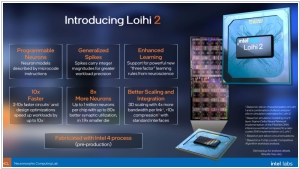

2021. Intel представила второе поколение нейроморфного чипа Loihi

Компания Intel представила новую итерацию нейроморфной программы, в том числе, второе поколение чипа Loihi, а также открытый фреймворк для разработки нейроморфных приложений Lava. Loihi 2 содержит до 1 млн «нейронов» на чипе и в десять раз быстрее предыдущей версии. Плотность ресурса в 15 раз больше, а энергоэффективность - лучше. Что касается Lava, то эта система отвечает потребностям программного фреймворка для сообщества исследователей нейроморфных вычислений. Она позволяет ученым и разработчикам приложений работать с принятым набором инструментов, методов и библиотек на обычных и нейроморфных процессорах, а также создавать программы, не имея доступа к специализированному железу.

2021. IBM представила первый процессор для мейнфреймов со встроенным ИИ-ускорителем

IBM представила свой первый процессор для мейнфреймов со встроенным ИИ-ускорителем - IBM Telum. Процессор оснащен специализированным ускорителем на кристалле для выводов ИИ, а его конструкция повышает производительность, безопасность и доступность, утверждает производитель. Чип содержит 8 процессорных ядер с тактовой частотой более 5 ГГц, каждое ядро поддерживается модернизированным частным кэшем второго уровня объемом 32 МБ. Кэши второго уровня вместе образуют 256 МБ виртуального кэша третьего уровня и 2 ГБ кэша четвертого уровня. Этот чип является первым, созданным Центром IBM Research AI Hardware Center. Компания ожидает, что финансовые фирмы будут использовать чип для предотвращения мошенничества, а не просто для его обнаружения.

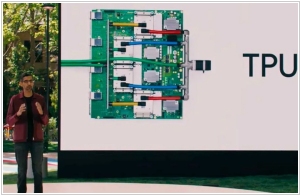

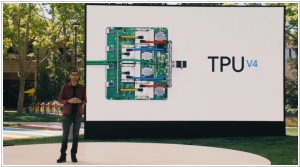

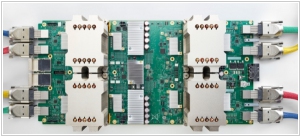

2021. Google запускает новое поколение своих ИИ-чипов

Google представил следующее поколение своих чипов Tensor Processing Units (TPU) AI. Это четвертое уже поколение, которое, по словам Google, в два раза быстрее, чем предыдущая версия. Как отметил генеральный директор Google Сундар Пичаи, эти чипы затем объединяются в блоки с 4096 v4 TPU. Один модуль обеспечивает более одного экзафлопа вычислительной мощности. Google использует ИИ-чипы для работы многих собственных сервисов машинного обучения, но он также сделает это последнее поколение доступным для разработчиков как часть своей платформы Google Cloud. В то время как другие, в том числе Microsoft, решив использовать более гибкие ПЛИС для своих сервисов машинного обучения, Google заранее сделала ставку на эти нестандартные микросхемы. На их разработку уходит немного больше времени, и они быстро устаревают по мере изменения технологий, но могут обеспечить значительно лучшую производительность.

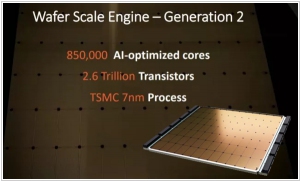

2020. Cerebras Systems представила 2 поколение своего нейрочипа

В прошлом году компания Cerebras System представила самый большой в мире процессор WSE, который включает 1,2 трлн транзисторов. Теперь они представили новый процессор CS-1, количество транзисторов в котором увеличится более чем в 2 раза — с 1,2 трлн до 2,6 трлн. Это стало возможным благодаря переходу на 7-нм техпроцесс. Кратно выросло и число ядер — их теперь 850 000. CS-1 в три раза производительней кластеров TPU от Google. Ожидается, что Cerebras System увеличит объем доступной памяти чипа и усилит межкомпонентные соединения микросхем для повышения пропускной способности. Скорее всего, компания продолжит предоставлять в аренду вычислительные мощности для обучения нейросетей корпоративных клиентов. Производителем процессора останется тайваньская Taiwan Semiconductor Manufacturing Company (TSMC).

2020. Intel представила самый мощный нейроморфный процессор

Компания Intel представила нейроморфный процессор Pohoiki Springs, вычислительная мощность которого составляет 100 млн нейронов. Его архитектура напоминает структуру мозга животного: обработка и хранение информации производится в одном месте — это позволяет экономить время, необходимое на выполнение операции, и энергию, затрачиваемую на нее. Новая система, согласно сообщению компании, будет работать через облако и станет доступна участникам исследовательского сообщества Intel Neuromorphic Research Community (INRC). Она позволит исследователям в рамках их проектов нейроморфных вычислений решать более масштабные и сложные задачи.

2019. Huawei хочет стать как Apple для Искусственного интеллекта

Компания Huawei представила свой процессор для систем машинного обучения - Ascend 910, который они называют самым быстрым ИИ-процессором в мире (на данный момент). Его вычислительная мощность - 256 терафлопс (триллионов операций в секунду). Для сравнения - у нового ИИ-чипа Intel - 180 терафлопс. Но это еще не все. Huawei разработала фреймворк для создания ИИ-приложений - MindSpore, который будет конкурировать с гугловским Tensorflow. Фишка в том, что он идеально использует ресурсы вышеупомянутого процессора. Т.е. за счет синергии харда и софта, Huawei хочет добиться в сфере ИИ того, чего добился Apple в производстве мобильных девайсов.

2019. Intel представила свой первый процессор для систем ИИ

Intel представила свой первый процессор, предназначенный для работы систем искусственного интеллекта - Nervana NNP-I. Он будет использоваться в крупных центрах обработки данных. Процессор был создан в центре разработки компании в Израиле на базе 10-нанометрового процессора Ice Lake. Он позволяет справляться с высокими нагрузками, используя минимальное количество энергии, говорят в Intel. Новый чип дополнит возможности серверных микропроцессоров Intel Xeon и поможет им справиться с ростом спроса на сложные вычисления в области ИИ.

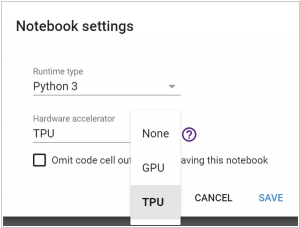

2018. Google добавил бесплатные TPU на Colaboratory

Google предоставил бесплатный доступ к своим тензорным процессорам (tensor processing unit, TPU) на облачной платформе для машинного обучения Colaboratory. Тензорный процессор — это специализированная интегральная схема (ASIC), разработанная Google для задач машинного обучения с использованием библиотеки TensorFlow. Colaboratory — это облачная платформа от Google для продвижения технологий машинного обучения. На ней можно получить бесплатно виртуальную машину с установленными популярными библиотеками TensorFlow, Keras, sklearn, pandas и т.п. Самое удобное, что на Colaboratory можно запускать ноутбуки, похожие на Jupyter. Ноутбуки сохраняются на Google Drive, можно их распространять и даже организовать совместную работу. Вот так выглядит ноутбук на Colaboratory

2017. TPU-чипы Google ускорят нейросети в 30 раз

Специалисты компании Google разработали специализированный процессор TPU (Tensor Processing Unit), имеющий производительность в 45 терафлопс. Такой процессор дает в 10–30 раз большую производительность для работы нейросетей, чем обычные процессоры и графические процессоры. При этом, эффективность работы тензорных процессоров превосходила эффективность других процессоров в 30–80 раз. Именно на тензорных процессорах работала система Alpha Go, которая одержала ряд впечатляющих побед над самыми именитыми игроками в китайскую игру Го. Немного позже в этом году система из тысячи таких процессоров, станет частью облачного сервиса Google Cloud Compute, доступ к которой совершенно бесплатно смогут получить разработчики систем машинного изучения.

2017. IBM представила твердотельные системы хранения для когнитивных задач

IBM выпустила полностью построенные на базе флэш-памяти системы хранения данных DS8888F, нацеленные на бизнес-решения для аналитики больших данных для приложений когнитивных вычислений. Система хранения предназначена для сложных приложений, требующих высокой доступности, бесперебойной работы и высокой производительности в любой момент времени. IBM DS8888F предназначается для предсказательной аналитики, оптимизации в реальном времени, машинного обучения и когнитивных систем, обработки речи на естественном языке и видео. Для этого у нее имеется 2 ТБ DRAM и флэш-память емкостью от 6,4 ТБ до 1,22 ПБ.

2016. IBM и Nvidia создали самый быстрый ИИ-сервер для бизнеса

Компании IBM и Nvidia представили, как они утверждают, самое быстрое в мире корпоративное решение для глубинного обучения. Это построенный на процессорах IBM Power 8 специализированный сервер IBM Power System S822LC, на котором запущена платформа искусственного интеллекта IBM PowerAI. Также, сервер получил новую шину на базе технологии Nvidia NVLink, которая обеспечивает пятикратное ускорение передачи данных между центральным и графическим процессором. Аппаратное средство прямого взаимодействия между CPU и GPU позволило увеличить производительность более чем вдвое по сравнению с сопоставимыми серверами с четырьмя GPU в тестовой нейросети AlexNet, построенной на фреймворке Caffe. Технологии глубинного обучения и искусственного интеллекта в целом все чаще используются в банковской отрасли (к примеру, для распознавания лиц), автомобилестроении (для беспилотных машин) и розничной торговле (для создания полностью автоматизированных колл-центров, способных понимать человеческую речь и отвечать на вопросы).

2016. IBM и Nvidia создали специализированный сервер для машинного обучения

Хотя IBM уже создала децентрализованный процессор для нейросетей TrueNorth, он пока еще не готов к коммерческой эксплуатации. Пока системы искусственного интеллекта работают на традиционной серверной архитектуре. Да, это требует больших компьютерных ресурсов и много энергии, зато надежно. И эти системы тоже можно оптимизировать. IBM совместно с Nvidia представили совместный продукт - IBM Power Systems S822LC. Он включает в себя два 8-ядерных центральных процессора IBM и четыре графических процессора Nvidia (именно графические процессоры в основном используются для моделирования нейросетей и их машинного обучения).

2016. На основе мозгоподобного чипа TrueNorth создали суперкомпьютер

Ливерморская национальная лаборатория (LLNL) занимается вопросами национальной безопасности США (в частности, разработкой ядерной бомбы). И всегда эта организация стремилась заполучить самые мощные суперкомпьютеры своего времени. Более того, сам термин "суперкомпьютер" был придуман именно в LLNL. Так вот, их последнее детище - суперкомпьютер, построенный на чипах IBM TrueNorth. Напомним, чипы TrueNorth - имеют архитектуру, схожую с нейронной сетью мозга. На данный момент суперкомпьютер имитирует сеть из 16 млн нейронов с примерно 4 млрд синапсов. Конечно, до мозга человека ему еще далеко, но самый мощный мозгоподобный компьютер из когда-либо созданных человеком. Для каких именно задач LLNL планирует использовать этот суперкомпьютер - конечно никто не узнает.